Wer ist eigentlich BERT und was hat er im Kundenservice zu suchen?

In der KI-Forschung haben wir in den letzten Jahren viele kleine Revolutionen erlebt. Erst in der Bild-, dann in der Texterkennung. Die Treiber dabei sind die Datenriesen wie z.B. Google oder Open-AI von Tesla. Was bedeuten diese Revolutionen für Unternehmen in Deutschland und der Schweiz? Good news, denn es profitieren davon nicht nur die grossen Player, sondern auch Unternehmen mit weniger Daten- und Rechenpower.

Für die Bilderkennung war lange Zeit die ImageNet Challenge [1] die Benchmark, die herangezogen wurde, um die Fortschritte auf diesem KI-Forschungsfeld zu messen. Bei dieser musste eine KI erkennen, was auf den Bildern zu sehen ist. Allein zwischen 2012 und 2017 verbesserte sich die KI in dieser Disziplin um 22% [2]. Inception Version 4 schaffte es schliesslich, über 80% der Bilder korrekt zu erkennen. Das ist eine Revolution. Die technischen Systeme werden nicht nur besser, sondern auch effizienter, d.h. schneller trainierbar.

Man vs. Machine: Wer macht das Rennen?

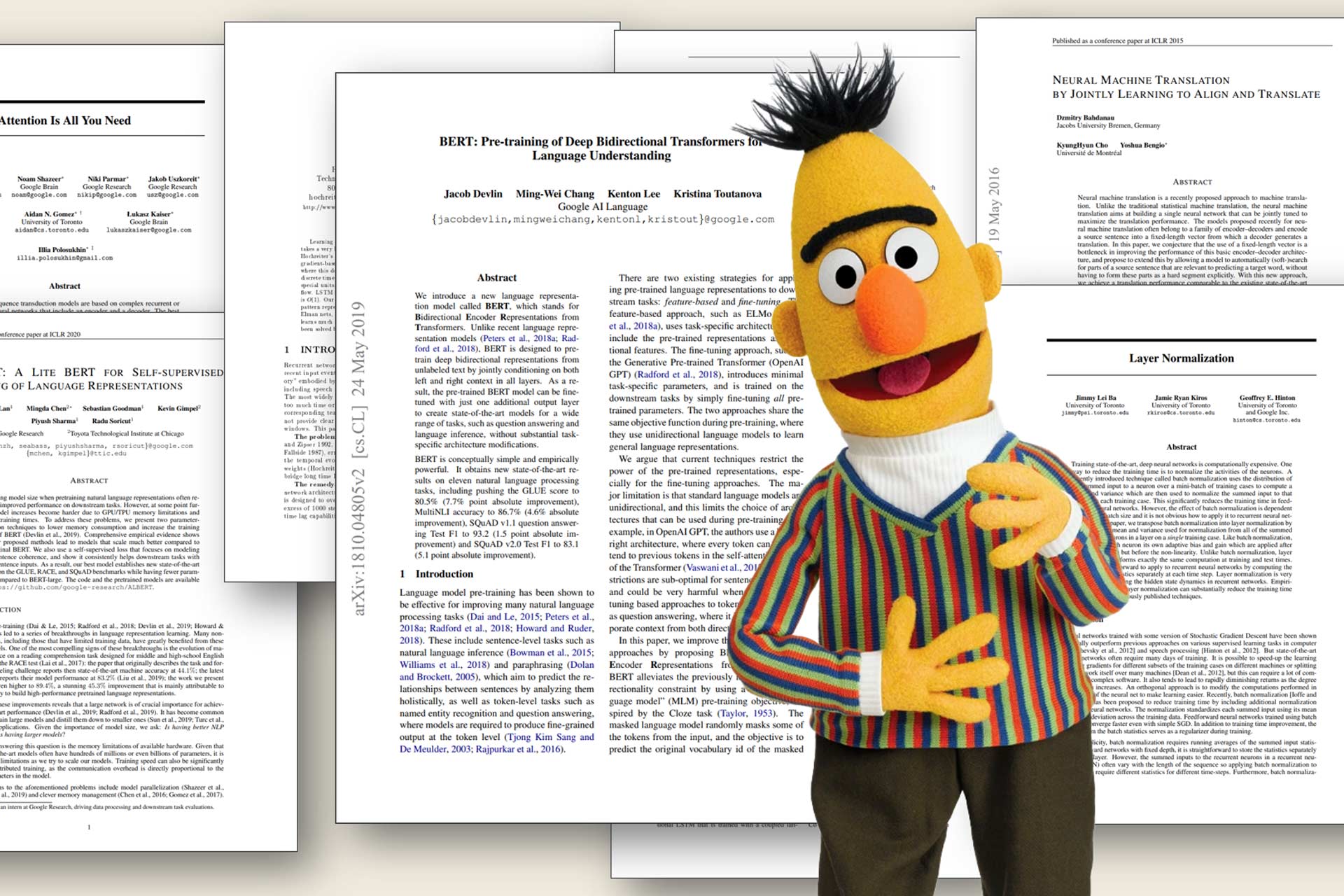

Das Modell zur Bilderkennung, das Tesla verwendet, ist beispielsweise bereits besser als der Mensch. Und auch in der Texterkennung erlebten wir zuletzt eine kleine Revolution. OpenAI mit ihrem Modell GPT-2, für das die Forscher 40 GB Text aus dem Internet genommen, ins Modell gepackt und trainiert haben, erzielten beeindruckende Resultate bei der Texterkennung. Das Forscherteam sah zuerst von einer Veröffentlichung ab, aus Sorge, da sich mit ihrem Modell ganz einfach und automatisiert Fake News generieren liessen. Mittlerweile wurde es aber veröffentlicht, nicht zuletzt, weil andere Modelle, wie z.B. BERT von Google auf den Markt kamen, die sogar noch besser performen. Vergleichen lassen sich solche Modelle mit der Stanford Question Answering Database [3]: Indem Sie zu ausgewählten Texten relevante Textstellen mit der Antwort auf die Frage hervorheben. Wenn die Maschine besser ist als der Mensch, dann kann getrost von einer Revolution gesprochen werden. Im März 2019 war es dann soweit: BERT schlug den Menschen beim Frage-Antwort-Spiel. Seither beantworten auf BERT-basierende Modelle über 90% der Fragen richtig! Im Vergleich dazu: Ein Mensch beantwortet im Durchschnitt nur knapp 87% korrekt [4].

Wie können wir BERT für Transfer Learning nutzen?

BERT wird in zwei Phasen trainiert: Zuerst unsupervised, dann supervised. In der unsupervised Phase nahm Google 3,3 Milliarden Wörter und liess das Modell sich damit selbst trainieren. BERT ist apropos multilingual, kann sich also alle möglichen Sprachen beibringen. In der anschliessenden supervised Phase verwendeten die Forscher 100 000 Fragen des Stanford Question Answering Datasets. Mit diesen fütterten sie BERT, wodurch das System lernte, die Fragen richtig zu beantworten.

Phase 1 ist sehr teuer und aufwendig. Würde ich diese selbst durchführen wollen, bräuchte ich acht NVIDIA V100-Grafikkartn, wovon eine bei rund CHF 20 000 liegt. Würde ich mit diesen das Modell 50 bis 70 Tage trainieren [5], käme ich zum Ergebnis, das Google mit BERT in der unsupervised Phase erzielte. Das ist aber zum Glück gar nicht nötig, denn Google stellt seine trainierten Modelle öffentlich zur Verfügung. Also muss ich mich nur noch um Phase 2 kümmern. Dafür reicht ein Gaming-PC mit einer etwas schnelleren Grafikkarte und wenige Stunden Training. Klasse, oder?

E-Mail-Klassifizierung im Retail – und was das Pflegeheim damit zu tun hat

Die Spezialisierung des Modells passiert also erst im zweiten Schritt, in der unsupervised Phase. Und der grosse Vorteil dabei ist: Es braucht hier viel weniger Daten. Nutzen wir das in der supervised Phase trainierte Modell und trainieren dieses dann in der zweiten Phase auf unser spezifisches Problem um, nennt man das Transfer Learning.

Diese Methode haben wir uns zunutze gemacht und mit CRM-Daten, die uns freundlicherweise von einem unserer Retailkunden zur Verfügung gestellt wurden, BERT für die E-Mail-Klassifizierung eingesetzt. In der unsupervised Phase wollten wir herausfinden, ob es sich bei einer eintreffenden E-Mail im Kundenservice um eine Sendungsverfolgung, eine Webereduktion, eine Bestellung oder eine Reklamation handelt. Das ist deshalb relevant, weil diese Anliegen von verschiedenen Teams beantwortet werden und unterschiedliche Antworten erfordern. Wir testeten, ob mithilfe von BERT eine Werbereduktion und eine Sendungsverfolgung korrekt vorhergesagt werden können.

Und das klappte sehr gut, da der Algorithmus gelernt hat, welche Worte mit grosser Wahrscheinlichkeit auf das eine oder das andere hindeuten. So hatte das System beispielsweise gelernt, dass das Wort Pflegeheim mit grosser Sicherheit auf den Wunsch nach Katalogabmeldung hindeutet. Dafür müssen Sie wissen, dass die Daten, die wir für die Experimente erhalten haben, von einem Retailer mit älterer Zielkundschaft stammen.

«Bitte nehmen Sie meinen Papa aus Ihrem Kundenverzeichnis. Er ist ins Pflegeheim ungezogen.» Grüne Wörter weisen in unserem Experiment auf Werbereduktion hin, die roten sprechen dagegen.

95% Erfolgsquote bei der E-Mail-Klassifizierung für unseren Retailkunden

Wir erzielten eine Erfolgsquote von fantastischen 95% bei den Klassifizierungen der E-Mails. Aber hier fängt es erst an, spannend zu werden. Dieses KI-generierte Wissen sollte dann von Unternehmen auch dafür genutzt werden, intelligente automatisierte Prozess zu entwickeln, mit denen Mitarbeitende entlastet werden und Kunden schnell, kompetent und personalisiert weitergeholfen wird. So könnte im Falle einer Sendungsverfolgung nach einer automatischen Betrugserkennung durch eine KI automatisch eine E-Mail mit der Sendungsverfolgungs-Nummer an den Kunden verschickt werden. Und viele weitere Anwendungsfälle sind denkbar.

Sie haben Ideen für Use Cases oder Fragen zum Thema Transfer Learning? Dann freue ich mich, von Ihnen zu hören!

Zum Nachhören und -Schauen: https://www.youtube.com/watch?v=Ca9gFe2TcOE&feature=youtu.be

Zum Nachlesen:

[1] http://www.image-net.org/challenges/LSVRC/

[2] https://arxiv.org/pdf/1605.07678.pdf

[3] https://rajpurkar.github.io/SQuAD-explorer/

[4] https://arxiv.org/pdf/1606.05250

[5] https://towardsdatascience.com/bert-technology-introduced-in-3-minutes-2c2f9968268c

Artikel teilen